Wat is de AI Act?

Technologie is een onderwerp dat voortdurend verandert en met opkomende technologieën die zich voortdurend ontwikkelen, moet ethische en verantwoorde ontwikkeling niet alleen worden overwogen, maar ook worden gewaarborgd. De Europese Unie (EU) ziet de urgentie van deze zaken in en heeft daarom regels opgesteld waar zowel bedrijven als individuen aan moeten voldoen. In deze geest werd de AI Act geïntroduceerd, die ervoor moet zorgen dat artificial intelligence (AI)-toepassingen die in de EU worden gebruikt, veilig, eerlijk en transparant zijn. Dit artikel analyseert de definitie van AI volgens de AI Act, hoe deze toepassingen indeelt in risicocategorieën en de gevolgen van deze categorieën.

De definitie van AI volgens de AI Act

Om AI effectief te reguleren, is het essentieel om eerst een precieze definitie van AI vast te stellen. Volgens de AI Act draaide de definitie van AI aanvankelijk om het idee dat AI toepassingen specifieke, welomschreven doelen hadden. Van AI toepassingen werd verwacht dat ze zouden werken binnen de grenzen van hun beoogde doelen zoals beschreven in hun documentatie. Een AI toepassing zou bijvoorbeeld ontworpen kunnen zijn voor afvalscheiding, een ander voor autonome voertuigbesturing. Deze toepassingen waren taakgericht en hun beoogde doelen waren duidelijk vermeld en gedocumenteerd.

Het landschap nam een wending toen toepassingen zoals ChatGPT opkwamen, die de vastgestelde AI definitie van de AI Act in twijfel trokken. ChatGPT heeft geen specifiek, vooraf gedefinieerd doel. Het is een breed en flexibel model dat een groot aantal taken kan uitvoeren. De snelle opkomst van ChatGPT was voor het Europees Parlement aanleiding om de AI Act snel aan te passen om dit probleem aan te pakken. Ze zagen in dat dit nieuwe type AI-model, vaak “foundation modellen” genoemd, niet netjes aansloot bij het vastgestelde begrip van AI toepassingen. Daarom moest de wetgeving worden aangepast aan dit veranderende landschap van AI. Momenteel zijn taakgerichte toepassingen die voor specifieke doeleinden zijn ontwikkeld en basismodellen zoals ChatGPT opgenomen in de AI Act.

Onaanvaardbaar risico, hoog risico & beperkt risico

‘Als de AI Act van kracht is, moeten organisaties beoordelen in welke risicocategorie hun AI-toepassingen vallen. De AI-Act onderscheidt drie risiconiveaus:

- Onaanvaardbaar Risico: Deze categorie omvat AI toepassingen die als zeer schadelijk worden beschouwd of ernstige risico’s vormen voor de veiligheid van personen, fundamentele rechten of maatschappelijke waarden. AI toepassingen die zijn ontworpen voor ‘social scoring’ zouden bijvoorbeeld zeker als onacceptabel worden geclassificeerd. Alle toepassingen die geacht worden een onaanvaardbaar risico te hebben, zijn verboden.

- Hoog risico: Toepassingen op gebieden gespecificeerd in Bijlage II van de AI Act, zoals transport (treinen, vliegtuigen, enz.), worden automatisch als hoog risico beschouwd. Deze categorisering is grotendeels te wijten aan de mogelijke gevolgen van AI-fouten op deze kritieke gebieden, die aanzienlijke risico’s voor de openbare veiligheid en het welzijn kunnen opleveren.

- Beperkt Risico: Toepassingen die niet voldoen aan de criteria van onaanvaardbaar risico of hoog risico worden geclassificeerd als beperkt risico.

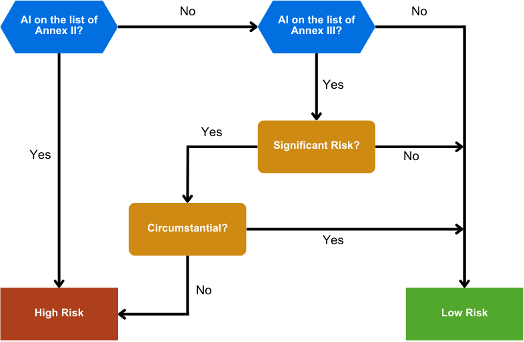

Onderscheid maken tussen deze drie risicocategorieën is niet altijd eenvoudig. Zo kunnen toepassingen op gebieden die in Bijlage III worden beschreven, zoals verzekeringen of toegang tot onderwijs, afhankelijk van verschillende factoren een hoog of een laag risico vormen. In deze gevallen wordt beoordeeld of er een aanzienlijk risico bestaat voor de fundamentele rechten en vrijheden, en zo ja, of dat risico aanzienlijk wordt geacht.

Als blijkt dat de toepassing de fundamentele rechten in onaanvaardbare mate kan schenden, wordt deze geclassificeerd als zeer riskant. Als er een significant risico ontstaat door onopzettelijk of indirect primair gebruik van de AI, wordt de AI toepassing geclassificeerd als beperkt risico.

De volgende grafiek verduidelijkt dit classificatieproces:

Wat zijn de gevolgen van deze classificaties?

De volgende grafiek verduidelijkt dit classificatieproces: Als AI als beperkt risico wordt beschouwd, zijn er minimale transparantievereisten. In dat geval moet een bedrijf gebruikers laten weten dat ze te maken hebben met een AI toepassing. Wanneer AI wordt geclassificeerd als hoog risico, zijn de vereisten uitgebreid. Bedrijven moeten ervoor zorgen:

- Transparantie en (Technische) Documentatie: Ontwikkelaars moeten gedetailleerde documentatie aanleveren over het ontwerp, de ontwikkeling en de functionaliteit van de AI toepassing. Dit omvat informatie over het beoogde doel, de beperkingen en mogelijke risico’s van de AI toepassing.

- Registratie: Ontwikkelaars moeten een administratie bijhouden van alle AI toepassingsactiviteiten, inclusief updates, onderhoud en incidenten. Deze gegevens moeten gedurende een passende periode worden bewaard, afhankelijk van het model.

- Informatie voor Gebruikers: Gebruikers van AI toepassingen met een hoog risico moeten duidelijke en begrijpelijke informatie krijgen over de mogelijkheden en beperkingen van het AI model. Ze moeten zich ervan bewust zijn dat ze interactie hebben met een AI-toepassing.

- Menselijk Toezicht: AI-toepassingen met een hoog risico moeten procedures hebben voor menselijk toezicht en interventie. Gebruikers moeten de controle kunnen overnemen of de beslissingen van de AI kunnen opheffen, vooral in situaties waarin dit risico’s met zich mee kan brengen.

Laatste Opmerkingen over de AI Act

De AI Act vormt de basis voor een uitgebreid kader voor AI Governance, waarin verschillende aspecten van AI-risico, -documentatie en -transparantie aan bod komen. In ons volgende artikel over de AI Act zullen we dieper ingaan op de lopende discussies rond de AI Act, de wereldwijde context waarin de AI Act wordt ontwikkeld en belangrijke data met betrekking tot de AI Act.

Wil je meer weten over de AI Act of heb je hulp nodig bij AI Governance? Aarzel niet om contact op te nemen via e-mail of het contactformulier op onze website!

Veelgestelde vragen:

De AI Act probeert ervoor te zorgen dat artificial intelligence (AI) toepassingen die in de EU worden gebruikt veilig, eerlijk en transparant zijn. Dit artikel analyseert de definitie van AI volgens de AI Act, hoe het toepassingen indeelt in risicocategorieën en de gevolgen van deze categorieën. '

Deze categorie omvat AI-toepassingen die als zeer schadelijk worden beschouwd of ernstige risico's vormen voor de veiligheid van personen, fundamentele rechten of maatschappelijke waarden. AI toepassingen die zijn ontworpen voor 'social scoring' zouden bijvoorbeeld zeker als onacceptabel worden geclassificeerd. Alle toepassingen die geacht worden een onaanvaardbaar risico te hebben, zijn verboden.

Toepassingen op gebieden gespecificeerd in Bijlage II van de AI Act, zoals transport (treinen, vliegtuigen, enz.), worden automatisch als hoog risico beschouwd. Deze categorisering is grotendeels te wijten aan de mogelijke gevolgen van AI-fouten op deze kritieke gebieden, die aanzienlijke risico's voor de openbare veiligheid en het welzijn kunnen opleveren.

Modellen die niet voldoen aan de criteria van onaanvaardbaar risico of hoog risico worden geclassificeerd als beperkt risico.

Bedrijven moeten er onder andere voor zorgen dat:

- Transparantie en (Technische) Documentatie

- Registratie

- Informatie voor Gebruikers

- Menselijk Toezicht

Dit vereist goede Data Governance/Intelligence